-

Постов

477 -

Зарегистрирован

-

Посещение

-

Победитель дней

7

admin стал победителем дня 10 февраля

admin имел наиболее популярный контент!

Репутация

352 ВеликолепнаяЛичная информация

- Профиль в Telegram

-

Здравствуйте, если задание не выполнилось в течение 20 минут, значит что-то зависло на стороне Telemgram - а это вполне возможно, так как мессенджер блокируют часто. Если вам не пришла генерация, то деньги ни за что не спишут - наш сервис снимает средства только за выполненные задания. Если что-то не сработало, то делайте запросы на генерации повторно - это касается всех нейросетей, а не только нано банана.

-

Да, мы уже разрабатываем сайт с доступом ко всем нейросетям. Доступ не потеряете. О реализации WEB-версии сообщим в новостях.

-

Пока такое нейронки не умеют делать нормально

-

Как создать семейный портрет с помощью нейросети

admin прокомментировал Anastassia изображение в галерее в Видео из нейросетей

на каждого человека по 1 фото. лучше всего если будут фотографии в профиль - в этом случае будет более высокая точность.- 3 комментария

-

- original

- семейное фото

- (и ещё 6 )

-

nanobanana Небесная и адская война: эпическое столкновение света и тьмы в небесах. Генерация из нейросети NanoBanana

admin опубликовал изображение в галерее в Nano Banana примеры промтов

Небесная и адская война: эпическое столкновение света и тьмы в небесах - Пример изображения, сгенерированного нейросетью NanoBanana Взрывной конфликт между небесным воинством ангелов и адскими полчищами демонов разворачивается в грандиозной схватке добра со злом, символизирующей вечную борьбу Рая и Преисподней. В вышине небеса озарены сияющим золотым светом, исходящим от облаков, сотканных из эфирной энергии. Величественные ангелы с могучими крыльями, мерцающими нимбами и искусно выполненными доспехами из чистого золота парят в небесах с грацией и решимостью. Они вооружены сверкающими мечами и божественными копьями, их лица спокойны, но полны неистовой воли к победе. Внизу земля разверзается, обнажая огненные глубины Ада. Пламя и раскаленная лава освещают мрачный, каменистый пейзаж под темными, окутанными дымом небесами. Из этих адских безн с яростью вырываются ужасающие демоны с искаженными крыльями, напоминающими перепонки летучих мышей. Их облик чудовищен и страшен: рога, багровые глаза, почерневшие доспехи с шипами. Одни властвуют над огненным оружием, другие – над клинками тени. Две армии сталкиваются на границе неба и земли: ослепительный свет против хаотичной тьмы. Вспышки молний и потоки пламени пронзают сцену; мечи скрежещут друг о друга; магия и сверхъестественные силы извергаются буйством красок. Разбросанные повсюду руины и выжженная земля – свидетельства их разрушительной борьбы. На заднем плане видны сияющие врата Рая, контрастирующие с далекими зловещими крепостями Ада и огненными безднами. Каждая деталь наполнена интенсивностью: динамичное движение, бушующие облака, летающие искры, разорванные знамена, брошенные копья, падающее перо, ломающиеся крылья демонов. Все это создает ощущение грандиозности и эпичности вечного противостояния, захватывая масштаб, эмоциональную драму и фантастическую энергию этой великой битвы, представленной в кинематографической перспективе. Зритель погружается в мир невероятной силы и мощи ✏️ Промт: an epic battle scene between angels and demons, symbolizing the clash between Heaven and Hell. High above, the heavens glow with radiant, golden light, shining from clouds that swirl with ethereal energy. Majestic angels with powerful, feathered wings, glowing halos, and elaborately crafted golden armor soar gracefully through the sky. They wield shining swords and divine spears, their faces serene yet fierce with determination. Below, the ground cracks open, revealing the fiery depths of Hell. Flame and molten lava light up a bleak, rocky landscape beneath dark, smoke-filled skies. From these infernal chasms, terrifying demons emerge, their twisted, bat-like wings beating furiously. The demons are monstrous and fearsome, with horns, crimson eyes, and blackened, spiked armor; some wield jagged weapons wreathed in flames or shadow. The two armies collide at the border of sky and earth: dazzling light against chaotic darkness. Lightning and fire streak through the scene; swords clash; magic and supernatural forces burst in vivid colors. Sparse ruins and charred earth—evidence of their cataclysmic struggle—are scattered about. In the backdrop, glimpses of Heaven's shining gates contrast against distant, ominous infernal fortresses and flaming pits. Every detail vibrates with intensity—the dynamic movement, swirling clouds, flying embers, torn banners, thrown spears, feathers spiraling down, and demon wings shattering. Emphasize a grand, cinematic perspective that captures the scale, emotional drama, and fantastical energy of this grand, eternal battle. 🧩 Нейросеть: 🍌 Nano Banana v.1.0 Pro 🎭 Стили: No style Картинка создана с помощью нейронной сети - Yes Ai Bot -

nanobanana Ангельский смех над самодовольным богачом в роскошном пентхаусе с видом на город. Нейронная сеть Nano Banana

admin опубликовал изображение в галерее в Nano Banana примеры промтов

Ангельский смех над самодовольным богачом в роскошном пентхаусе с видом на город - Генерация в нейросети Nano Banana Завораживающая сцена воплощает столкновение двух миров: небесной невинности и земного богатства. В центре композиции – прекрасный ангел с лучистыми белыми крыльями и золотым нимбом, чья радостная улыбка излучает чистоту и свет. Её длинные шелковистые волосы струятся вокруг лица, а изящное белоснежное платье переливается нежными оттенками. Взгляд ангела направлен на уверенного в себе богача, стоящего рядом. Он воплощает силу и власть – дорогой костюм безупречного кроя, роскошный галстук, отчесанные назад волосы и самодовольная улыбка выдают его статус. На запястье сверкает дорогая часовая марка, украшенная бриллиантами, а между пальцами он держит недокуренный сигар, из которого поднимается тонкая струйка дыма. Действие разворачивается в роскошном пентхаусе с панорамным видом на ночной город, где сверкающие небоскребы устремляются ввысь. Теплое золотое освещение подчеркивает контраст между небесным сиянием ангела и материальным окружением мужчины. Мраморные полы, бархатные кресла, хрустальная люстра и обилие золотых деталей создают атмосферу изысканности и роскоши. Сцена пронизана игривым юмором и чувством неземной грации, демонстрируя неожиданное сочетание чистоты и мирской роскоши. Картина выполнена в высочайшей детализации, с гиперреалистичным освещением и ультра-четкой фокусировкой, что позволяет рассмотреть каждую деталь: выразительные лица, сложные текстуры крыльев и одежды, тонкие отражения света. Это кинематографическое произведение искусства, поражающее своим фотореализмом и мастерством исполнения в формате 4K ✏️ Промт: A beautiful, ethereal female angel laughing joyfully, her radiant white wings slightly spread, golden halo glowing softly above her head. She has long, flowing, silky hair, her features are delicate and luminous, wearing a flowing white dress that shimmers with subtle iridescent hues. Her laughter is genuine and graceful, her eyes sparkling with warmth and intelligence, as she looks down at a confident, slightly arrogant rich man. The man stands nearby, exuding self-assurance and pride, wearing an expensive, perfectly tailored dark suit with a luxurious tie. He has slicked-back hair and a charming, smug expression. On his wrist is a shiny, intricate high-end watch encrusted with diamonds. He is holding an elegant, half-burnt cigar between his fingers, from which a thin trail of smoke rises into the air. The setting is an opulent, modern penthouse suite with panoramic nighttime city views through floor-to-ceiling windows, sparkling skyscrapers outside. The room is bathed in warm, golden ambient lighting, highlighting the contrast between the angel's celestial glow and the man's materialistic aura. Refined details: marble floors, velvet armchairs, crystal chandelier, rich textures and gold accents throughout the interior. The overall atmosphere combines playful humor and a sense of otherworldly grace, capturing the contrast between innocence and worldly luxury. Highly detailed, hyper-realistic, cinematic lighting, 4K, photorealism, ultra-sharp focus, expressive faces, intricate textures in clothing and wings, subtle reflections and light effects. 🧩 Нейросеть: 🍌 Nano Banana v.1.0 Pro 🎭 Стили: BioCyber Это изображение сгенерировано в Yes Ai Bot -

sora Нежданный союз: грешник и небесное создание в объятиях противоречий. Картинка из нейронной сети Sora images Ai

admin опубликовал изображение в галерее в Sora Images примеры промтов

Нежданный союз: грешник и небесное создание в объятиях противоречий - Картинка из нейросети Sora images Ai Контраст характеров и миров воплощен в этой поразительной диптихе. Перед нами перед лицом зрителя разворачивается история о темной стороне души и невинности, о грехе и прощении. Мужчина, окутанный аурой роскоши – дорогой костюм, бокал виски, дымящаяся сигара – излучает порочность и неоднозначность. Седая борода добавляет образу загадочности и намекает на прожитые годы, наполненные, возможно, не самыми светлыми поступками. Он словно воплощение искушения, соблазна и запретных желаний. Рядом с ним – девушка-ангел, сияющая чистотой и добродетелью. Ее небесный нимб и пронзительные голубые глаза выражают осуждение, непоколебимую веру в справедливость и неприятие греха. Она – олицетворение морали, света и надежды на искупление. Взгляд девушки полон скорби и разочарования, словно она видит сквозь маску благополучия истинное лицо человека, стоящего рядом. Эта картина – метафора вечной борьбы добра и зла, света и тьмы, что происходит внутри каждого из нас. Это размышление о природе человеческой души, ее способности к падению и возможности возрождения. Зритель оказывается перед выбором: увидеть в мужчине лишь негодяя или почувствовать отголоски его трагичной судьбы? И сможет ли ангел простить его грехи и подарить надежду на новую жизнь? Картина заставляет задуматься о хрупкости человеческой морали, силе искупления и неизбежности расплаты. Это визуальная поэма о любви, предательстве и вечной борьбе между светом и тьмой, заключенная в одном взгляде ✏️ Промт: негодяй и ангел: парень с седой бородой в дорогом костюме с бокалом виски и сигарой, девушка ангел с нимбом и голубыми глазами с осуждением смотрит на парня 🧩 Нейросеть: 🦋 Sora Images 🎭 Стили: No style 🧩 Нейросеть: sora- 1 комментарий

-

- грех

- искупление

-

(и ещё 5 )

C тегом:

-

Антизолото: Загадка Элемента Без Молекулярной Структуры и Отражающих Свойств - Картинка, созданная нейросетью NanoBanana Антизолото – это концептуальное чудо, вызов привычным представлениям о драгоценностях и фундаментальным законам физики. Это не просто камень, а философская идея, воплощенная в материале. Представьте себе бриллиант, лишенный своей искры, зеркало, не отражающее реальность, музыку без мелодии и голоса – это антизолото. Оно существует за гранью обыденного восприятия, являясь отрицанием привычных характеристик. Этот элемент, словно призрак в мире материи, демонстрирует отсутствие фундаментальных свойств, присущих золоту. Это вызов для технологий, даже самые совершенные нейросети не способны создать подобное. Антизолото – это абсолютная пустота, заключенная в форму, это уникальный артефакт, лишенный экпозиции и окружения, существующий вне привычных категорий. Оно представляет собой загадку, манифест отрицания и одновременно символ бесконечного поиска новых форм выражения. Это нечто большее, чем просто драгоценность – это концепт, воплощенный в камне, это искусство отрицания, вызов для воображения и размышлений о природе бытия. Антизолото - уникальное сочетание науки и искусства, физики и эстетики, загадки и красоты ✏️ Промт: антизолото - элемент без молекул как зеркало без отражения антиматерия в мире драгоценностей бриллиант без блеска как песня без голоса как музыка без нот то, что не может создать даже нейросеть элемент без окружения без экпозиции 🧩 Нейросеть: 🍌 Nano Banana v.1.0 Pro 🎭 Стили: No style Это изображение создано алгоритмом ИИ - Yes Ai

-

sora Пришелец с Луны: Неоновый кошмар в лунном пейзаже и базе врагов. Генерация из нейросети Sora

admin опубликовал изображение в галерее в Sora Images примеры промтов

Пришелец с Луны: Неоновый кошмар в лунном пейзаже и базе врагов - Картинка, полученная с помощью нейросети Sora В безжалостных просторах Луны таится древняя угроза – воплощение ярости и хищного инстинкта. Этот злой житель спутника Земли, словно кошмарный сон, возникший из глубин космоса, демонстрирует свою силу устрашающим оскалом. Его броня, созданная по технологиям далекого будущего, мерцает холодным светом редких красных неоновых линий, подчеркивая его чуждость и враждебность. Окруженный суровым лунным пейзажем, он является стражем таинственной лунной базы пришельцев – сооружения, скрывающего за своей стеной металла и технологий немыслимые секреты. Этот образ – символ вторжения, воплощение космического ужаса, напоминание о том, что в бездне космоса обитают существа, превосходящие человеческое понимание и представляющие смертельную опасность. Его присутствие на Луне — это предзнаменование грядущей бури, угрозы для всего человечества, чья судьба теперь висит на волоске. Суровая красота лунного ландшафта лишь усиливает ощущение безнадежности перед лицом этого могущественного противника, рожденного в ледяной пустоте и жаждущего завоевать новые миры. Его взгляд полон ненависти, а его сила кажется безграничной. Он – кошмарная реальность, воплощенная на поверхности Луны ✏️ Промт: злой житель луны, хищный оскал пришельца, броня из будущего с не немногочисленными красными неоновыми линиями, лунный пейзаж, лунная база пришельцев. 🧩 Нейросеть: 🦋 Sora Images 🎭 Стили: No style 🧩 Нейросеть: sora -

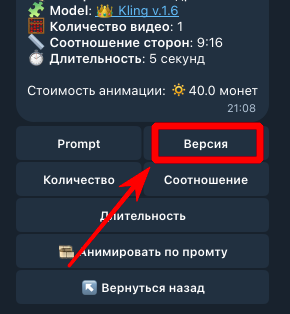

Вообще-то в боте давно можно менять версию нейросети, это я про тезис "да и клинг версию бы поднять с 1.6"... С чего вы решили, что доступна только 1.6 ?

-

Реставрацию фото лучше делать в Qwen Images вот тут https://t.me/yes_ai_bot?start=_restore Оживлять можно в Veo 3, вот инструкция - https://forum.yesai.su/topic/2290-kak-generirovat-memy-pro-neyrobabku-v-neyroseti-veo-3/

.thumb.png.12df6db636c631b212fced979a8f74af.png)